OpenAI改变策略:英伟达根本逻辑受影响?撒谎者是谁?

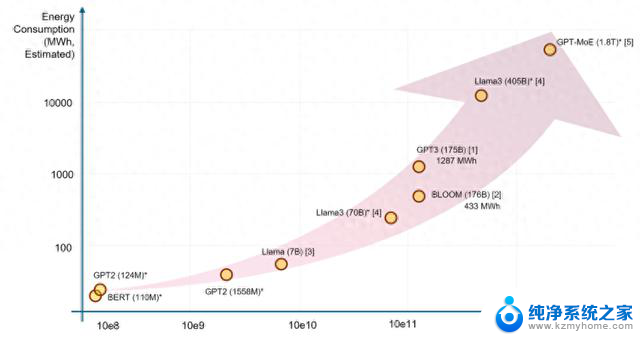

“缩放定律”指导下,AI大模型预训练目前遭遇瓶颈。据路透12日报道,硅谷主要AI实验室的新模型训练计划目前普遍进展不顺,新模型训练遭遇拖延和令人失望的结果。比起GPT-4o,Orion被曝几乎没有任何改进,谷歌的Gemini 2.0也存在类似问题。

为克服瓶颈,OpenAI正探索“测试时计算”(training runs)技术,让模型不再受限于预训练,而能够以多步骤方法思考问题(推理)来提升表现。报道称,相关技术的应用最终推动OpenAI发布o1模型。

这可能会改变人工智能硬件的竞争格局。

目前为止,AI硬件市场主要由对英伟达训练芯片的无限需求主导。但如果通过增加训练时间和测试(推理)时间,模型就能获得更好的结果,那新一代模型可能就不再需要那么大的参数,较小的模型将直接降低成本。市场需求或将从大规模预训练集群转向推理云,英伟达在推理芯片市场可能会面临更多竞争。

“缩放定律”面临挑战硅谷主要AI实验室的新模型训练目前普遍进展不顺。

据科技媒体The Information报道,OpenAI开发的下一个旗舰模型“Orion”,目前已经完成20%的训练。尽管表现已接近现有的GPT-4,但进步幅度却远不如前两代旗舰模型之间的飞跃。

Orion在语言任务上表现更好,但在编码等任务上可能不会优于以前的模型。且与最近发布的其他模型相比,OpenAI在其数据中心运行 Orion 的成本可能更高。

Orion的进展放缓直接挑战了人工智能领域一直奉行的“缩放定律”,即在数据量和计算资源不断增加的前提下,模型性能将持续大幅度提升。

当年最早将“缩放定律”应用于实践,并最终成功创造出ChatGPT的前Open AI联合创始人Ilya Sutskever在接受路透采访时直言,AI模型扩展训练的结果,已经趋于平稳。通过在预训练中使用更多的数据和算力,让AI模型性能暴涨的阶段可能已经到头了:

Ilya透露,他的团队正在研究一种全新的替代方法,来扩展预训练。

“测试时计算”会是破局方法吗?OpenAI则极力否认AI模型训练面临瓶颈。作为应对,OpenAI研究人员正在探索一项“测试时计算”(training runs)的技术。十几位AI科学家、研究人员和投资者告诉路透社,他们认为正是这些技术,推动了OpenAI发布o1模型。

所谓测试时计算技术,是指在推理阶段(模型被使用时)就将模型增强,让模型可以实时生成和评估多种可能性,而不是理解选择单一答案,最终选择出最佳路径。

这种方法可以允许模型将更多的处理能力,用于数学、编码问题等具有挑战性的任务,及需要类人推理和决策的复杂操作。

在新技术的运用下,o1在GPT-4等基础模型上进行另一套训练。该模型不再受限于预训练,而能够以多步骤方法思考问题(类似于人类推理)来提升表现。o1还涉及了来自博士和行业专家策划的数据和反馈。

参与o1开发的OpenAI 研究员在上个月TEDAI大会上直言:

英伟达垄断地位有望打破?其他科技巨头也在积极跟进。

路透援引多名知情人士报道称,来自Anthropic、xAI 和 Google DeepMind 等其他顶尖人工智能实验室的研究人员也在开发自己的技术版本的“测试时计算”。

这可能会改变人工智能硬件的竞争格局。

目前为止,AI硬件市场主要由对英伟达训练芯片的无限需求主导。但如果通过增加训练时间和测试(推理)时间,模型就能获得更好的结果,那新一代模型可能就不再需要那么大的参数,较小的模型将直接降低成本。

从红杉资本到 Andreessen Horowitz 等知名风险投资公司,他们已经投入数十亿美元资助 OpenAI 和 xAI 等多个人工智能实验室昂贵的人工智能模型开发,他们正在关注这一转变,并权衡其昂贵赌注的影响。

红杉资本合伙人 Sonya Huang 向路透社表示:

这或许打破英伟达在训练芯片领域的垄断地位,公司在推理芯片市场可能会面临更多竞争。类似Groq的推理芯片公司或能“撕开”行业缺口。

英伟达也坦诚推理芯片需求的变化,在上个月印度演讲中。黄仁勋谈到了新技术对芯片进行推理的需求不断增加,强调了 o1 模型背后的技术的重要性:

本文来自华尔街见闻,欢迎下载APP查看更多